什么是标准化

传统机器学习中标准化也叫做归一化,一般是将数据映射到指定的范围,用于除去不同维度数据的量纲以及量纲单位 。

数据标准化让机器学习模型看到的不同样本彼此之间更加相似,这有助于模型的学习与对新数据的泛化。

常见的数据标准化形式:

标准化和归一化

标准化:将数据减去均值除以方差,使得它的均值为0,标准差为1(打个问号)

批标准化

Batch Normalization,批标准化,和普通的数据标准化类似,是将分散的数据统一的一种做法,也是优化神经网络的一种方法。

不仅在将数据输入模型之前对数据做标准化,在网络的每一次变换之后都应该考虑数据标准化。(比如前一层网络输出后,进入下一层网络输入时,再做一次批标准处理。)

即是在训练过程中均值和方差随时间发生变化,它也可以适应性地将数据标准化。

批标准化解决的问题是梯度消失与梯度爆炸。批标准化是一种训练优化方法。

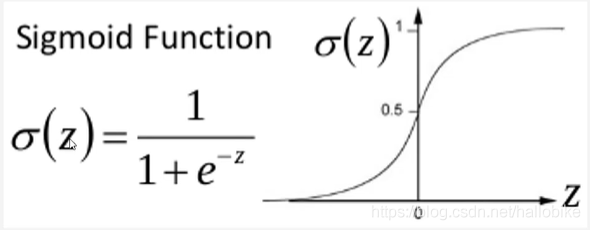

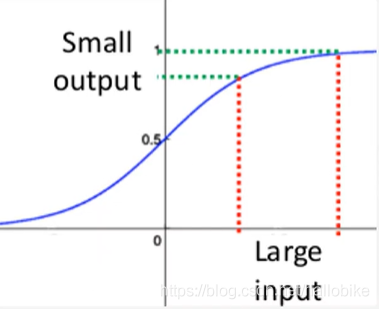

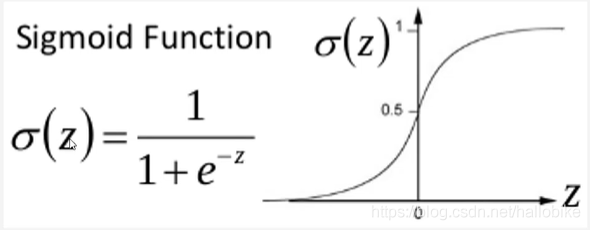

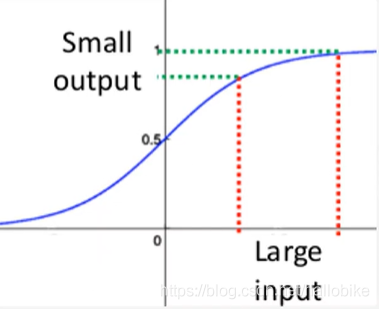

关于梯度消失,以sigmoid函数为例子,sigmoid函数使得输出在[0, 1]之间。

为什么要做批标准化

如果输入很大,其对应的斜率就很小,反向传播梯度就很小,学习速率就很慢。

批标准的好处

我们知道数据预处理做标准化可以加速收敛,同理,在神经网络使用标准化也可以加速收敛,而且还有更多好处。

1、具有正则化的效果(抑制过拟合)

2、提高模型的泛化能力

3、允许更高的学习速率从而加速收敛

批标准化有助于梯度传播,因此允许更深的网络。对于有些特别深的网络,只有包含多个BatchNormalization层才能进行训练。

批标准化的应用

BatchNormalization广泛应用于Keras内置的许多高级卷积神经网络架构,比如ResNet50、InceptionV3和Xception。

tf实现批标准化

BatchNormalization层通常在卷积层或密集连接层之后使用。

Tf.keras.layers.Batchnormalization()

批标准化的实现过程

1、求每一个训练批次数据的均值

2、求每一个训练批次数据的方差

3、数据进行标准化

4、训练参数γ,β

5、输出y通过γ与β的线性变换得到原来的数值

在训练的正向传播中,不会改变当前输出,只记录下γ与β;在反向传播的时候,根据求得的γ与β通过链式求导方式,求出学习速率以至改变权值。

批标准化的预测过程

对于预测阶段时所使用的均值和方差,其实也是来源于训练集。比如我们在模型训练时我们就记录下每个batch下的均值和方差,待训练完毕后,我们求整个训练样本的均值和方差期望值,作为我们预测时进行BatchNormalization的均值和方差。

批标准化的使用位置

training:Python布尔值,指示图层应在训练模式还是在推理模式下运行。

training=True:该图层将使用当前批输入的均值和方差对其输入进行标准化。

training=False:该层将使用在训练期间学习的移动统计数据的均值和方差来标准化其输入。

原始论文讲在CNN中一般应作用于非线性激活函数之前,但是,实际上放在激活函数之后效果可能会更好。

以卫星图像分类为例说明

# 建立模型

model = tf.keras.Sequential() # 顺序模型

model.add(tf.keras.layers.Conv2D(64, (3, 3), input_shape=(256, 256, 3)))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Activation('relu'))

model.add(tf.keras.layers.Conv2D(64, (3, 3)))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Activation('relu'))

model.add(tf.keras.layers.MaxPool2D())

model.add(tf.keras.layers.Conv2D(128, (3, 3)))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Activation('relu'))

model.add(tf.keras.layers.Conv2D(128, (3, 3)))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Activation('relu'))

model.add(tf.keras.layers.MaxPool2D())

model.add(tf.keras.layers.Conv2D(256, (3, 3)))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Activation('relu'))

model.add(tf.keras.layers.Conv2D(256, (3, 3)))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Activation('relu'))

model.add(tf.keras.layers.MaxPool2D())

model.add(tf.keras.layers.Conv2D(512, (3, 3)))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Activation('relu'))

model.add(tf.keras.layers.MaxPool2D())

model.add(tf.keras.layers.Conv2D(512, (3, 3)))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Activation('relu'))

model.add(tf.keras.layers.MaxPool2D())

model.add(tf.keras.layers.Conv2D(1024, (3, 3)))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Activation('relu'))

model.add(tf.keras.layers.GlobalAveragePooling2D())

model.add(tf.keras.layers.Dense(1024))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Activation('relu'))

model.add(tf.keras.layers.Dense(256))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Activation('relu'))

model.add(tf.keras.layers.Dense(1, activation='sigmoid'))

cs