tensor([[[[0.8824, 0.8824, 0.8824, ..., 0.8941, 0.8549, 0.7961],

[0.8784, 0.8824, 0.8784, ..., 0.9059, 0.8588, 0.7922],

[0.8824, 0.8784, 0.8784, ..., 0.9137, 0.8667, 0.7765],

...,

[0.3216, 0.3098, 0.3686, ..., 0.6863, 0.6824, 0.6824],

[0.3216, 0.3137, 0.3843, ..., 0.7059, 0.7137, 0.7059],

[0.3255, 0.3176, 0.3882, ..., 0.7020, 0.7216, 0.7216]],

[[0.5412, 0.5333, 0.5333, ..., 0.5843, 0.5176, 0.3922],

[0.5333, 0.5333, 0.5333, ..., 0.5882, 0.5216, 0.3922],

[0.5373, 0.5373, 0.5373, ..., 0.5765, 0.5098, 0.3804],

...,

[0.0863, 0.0706, 0.1176, ..., 0.2706, 0.2588, 0.2588],

[0.0863, 0.0745, 0.1333, ..., 0.2745, 0.2824, 0.2863],

[0.0902, 0.0784, 0.1373, ..., 0.2667, 0.2941, 0.2941]],

[[0.4745, 0.5020, 0.5176, ..., 0.4627, 0.4196, 0.3333],

[0.4784, 0.5020, 0.5176, ..., 0.4745, 0.4314, 0.3451],

[0.4902, 0.5020, 0.5098, ..., 0.4706, 0.4392, 0.3490],

...,

[0.2196, 0.2039, 0.2549, ..., 0.3255, 0.3098, 0.3098],

[0.2196, 0.2078, 0.2706, ..., 0.3176, 0.3255, 0.3255],

[0.2235, 0.2118, 0.2745, ..., 0.2941, 0.3176, 0.3176]]]])

flag = 0

if flag:

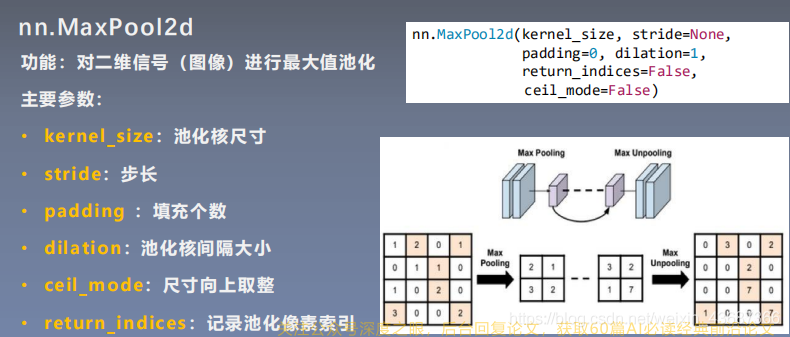

maxpool_layer = nn.MaxPool2d((2,2),stride=(2,2))

img_pool = maxpool_layer(img_tensor)

flag = 1

if flag:

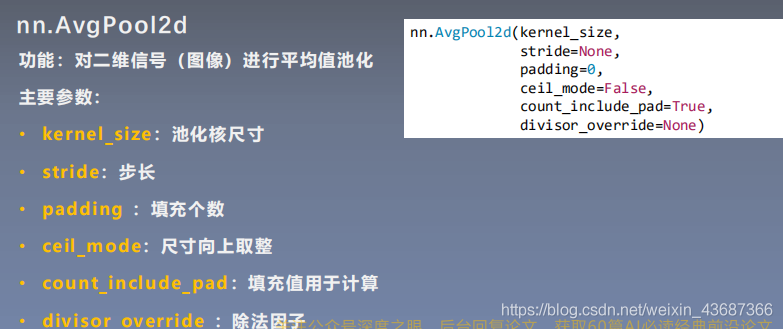

avgpool_layer = nn.AvgPool2d((2,2),stride=(2,2))

img_pool = avgpool_layer(img_tensor)

print("池化前尺寸:{}\n池化后尺寸:{}".format(img_tensor.shape,img_pool.shape))

img_pool = transform_invert(img_pool[0,0:3,...],img_transform)

img_raw = transform_invert(img_tensor.squeeze(),img_transform)

plt.subplot(122).imshow(img_pool)

plt.subplot(121).imshow(img_raw)

plt.show()

池化前尺寸:torch.Size([1, 3, 512, 512])

池化后尺寸:torch.Size([1, 3, 256, 256])

img_tensor = torch.ones((1, 1, 4, 4))

avgpool_layer1 = nn.AvgPool2d((2,2),stride=(2,2))

img_pool1 = avgpool_layer1(img_tensor)

avgpool_layer = nn.AvgPool2d((2, 2), stride=(2, 2), divisor_override=3)

img_pool = avgpool_layer(img_tensor)

print("img_pool1:\n{}".format(img_pool1))

print("raw_img:\n{}\npooling_img:\n{}".format(img_tensor, img_pool))

img_pool1:

tensor([[[[1., 1.],

[1., 1.]]]])

raw_img:

tensor([[[[1., 1., 1., 1.],

[1., 1., 1., 1.],

[1., 1., 1., 1.],

[1., 1., 1., 1.]]]])

pooling_img:

tensor([[[[1.3333, 1.3333],

[1.3333, 1.3333]]]])

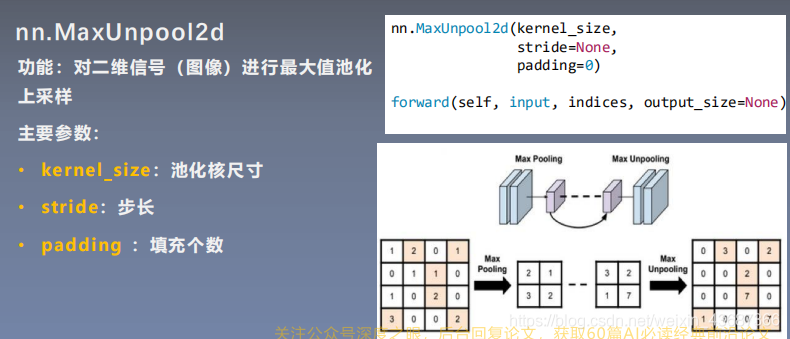

img_tensor = torch.randint(high=5,size=(1,1,4,4),dtype=torch.float)

maxpool_layer = nn.MaxPool2d((2,2),stride=(2,2),return_indices=True)

img_pool,indices = maxpool_layer(img_tensor)

img_reconstruct = torch.randn_like(img_pool,dtype=torch.float)

maxunpool_layer = nn.MaxUnpool2d((2,2),stride=(2,2))

img_unpool = maxunpool_layer(img_reconstruct,indices)

print("raw_img:\n{}\nimg_pool:\n{}".format(img_tensor,img_pool))

print("img_reconstruct:\n{}\nimg_unpool:\n{}".format(img_reconstruct, img_unpool))

raw_img:

tensor([[[[1., 4., 2., 3.],

[1., 4., 4., 3.],

[3., 3., 1., 2.],

[2., 3., 4., 3.]]]])

img_pool:

tensor([[[[4., 4.],

[3., 4.]]]])

img_reconstruct:

tensor([[[[ 0.8310, -0.2477],

[-0.8029, 0.2366]]]])

img_unpool:

tensor([[[[ 0.0000, 0.8310, 0.0000, 0.0000],

[ 0.0000, 0.0000, -0.2477, 0.0000],

[-0.8029, 0.0000, 0.0000, 0.0000],

[ 0.0000, 0.0000, 0.2366, 0.0000]]]])

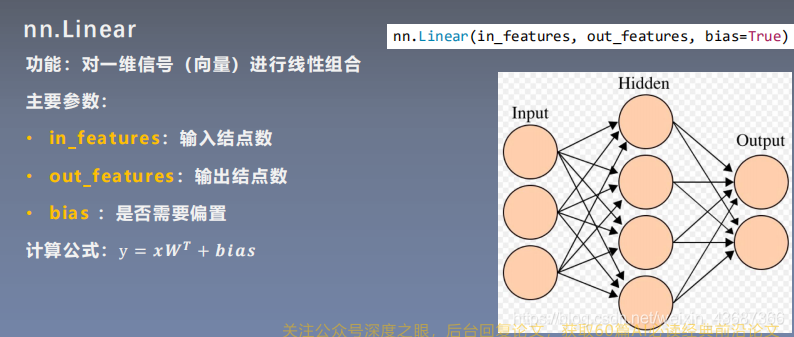

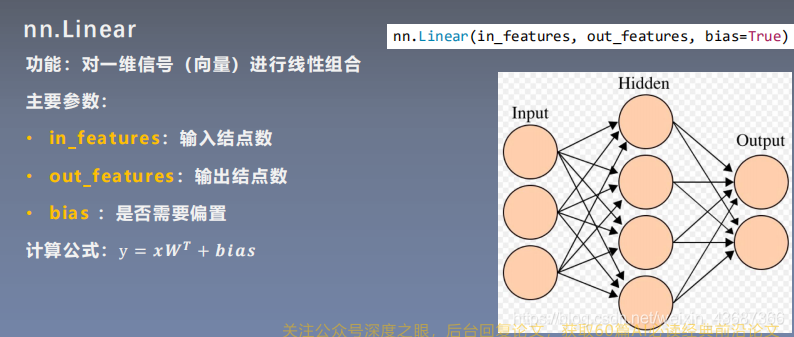

2、 线性层——Linear layer

inputs = torch.tensor([[1.,2,3]])

linear_layer = nn.Linear(3,4)

linear_layer.weight.data = torch.tensor([[1.,1.,1.],

[2.,2.,2.],

[3.,3.,3.],

[4.,4.,4.]])

linear_layer.bias.data.fill_(0.5)

output = linear_layer(inputs)

print(inputs,inputs.shape)

print(linear_layer.weight.data,linear_layer.weight.data.shape)

print(output,output.shape)

tensor([[1., 2., 3.]]) torch.Size([1, 3])

tensor([[1., 1., 1.],

[2., 2., 2.],

[3., 3., 3.],

[4., 4., 4.]]) torch.Size([4, 3])

tensor([[ 6.5000, 12.5000, 18.5000, 24.5000]], grad_fn=<AddmmBackward>) torch.Size([1, 4])

参考机器之心:激活函数