第一部分:直接获取!!!

1.目标URL:https://movie.douban.com/top250!

2.python中利用requests+etree+re+json+fake_useragent模块实现:(代码没有任何问题,可以随拿随用!)

import requests

from lxml import etree

import re

import json

from fake_useragent import UserAgent

def films(num):

page_url="https://movie.douban.com/top250?start={}&filter=".format(num)

headers={

"User-Agent": UserAgent().random

}

res=requests.get(page_url,headers=headers)

html=etree.HTML(res.text)

film_info = {}

films_info = html.xpath("//div[@class='info']")

with open("films_info.json", 'a',encoding='utf-8') as f:

for film_one in films_info:

film_name = film_one.xpath("./div/a/span[1]/text()")[0]

film_author_actor = film_one.xpath("./div[2]/p/text()")[0].strip()

if "主" in film_author_actor:

film_author_test = re.findall(': (.*)\\xa0',film_author_actor)[0].strip()

film_author = re.sub('\\xa0','',film_author_test)

else:

film_author_test = re.findall(': (.*)',film_author_actor)[0]

film_author = re.sub('\\xa0', '', film_author_test)

if "主演" in film_author_actor and len(re.findall('\\xa0主演: (.*)',film_author_actor))==1:

film_actor_test = re.findall('\\xa0主演: (.*)',film_author_actor)[0].strip()

film_actor = re.sub('\\xa0','',film_actor_test)

else:

film_actor = "空"

film_category_test = film_one.xpath("./div[2]/p/text()")[1].strip()

film_category = re.sub('\\xa0','',film_category_test)

film_score = film_one.xpath("./div[2]/div/span[2]/text()")[0]

film_info["film_name"] = film_name

film_info["film_author"] = film_author

film_info["film_actor"] = film_actor

film_info["film_category"] = film_category

film_info["film_score"] = film_score

content = json.dumps(film_info,ensure_ascii=False) + "," + "\n"

f.write(content)

for i in range(9):

films(i*25)

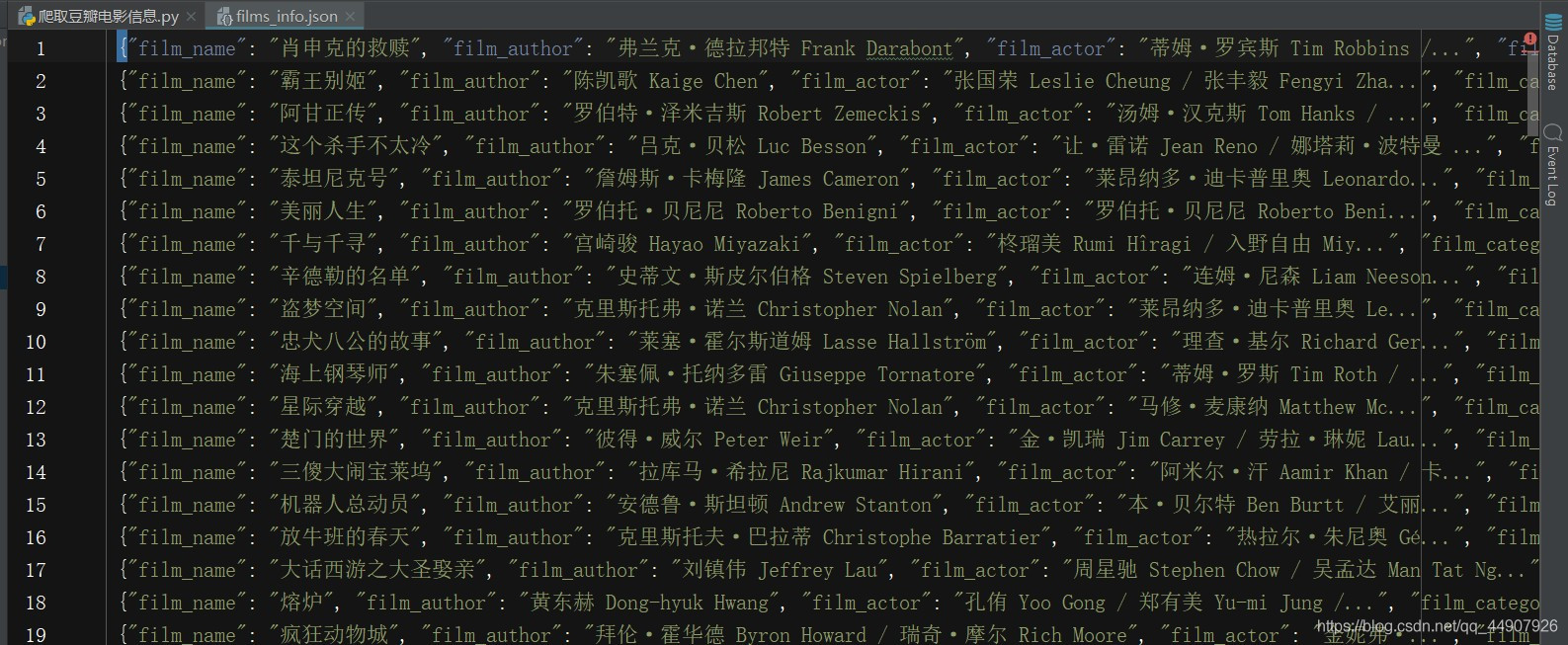

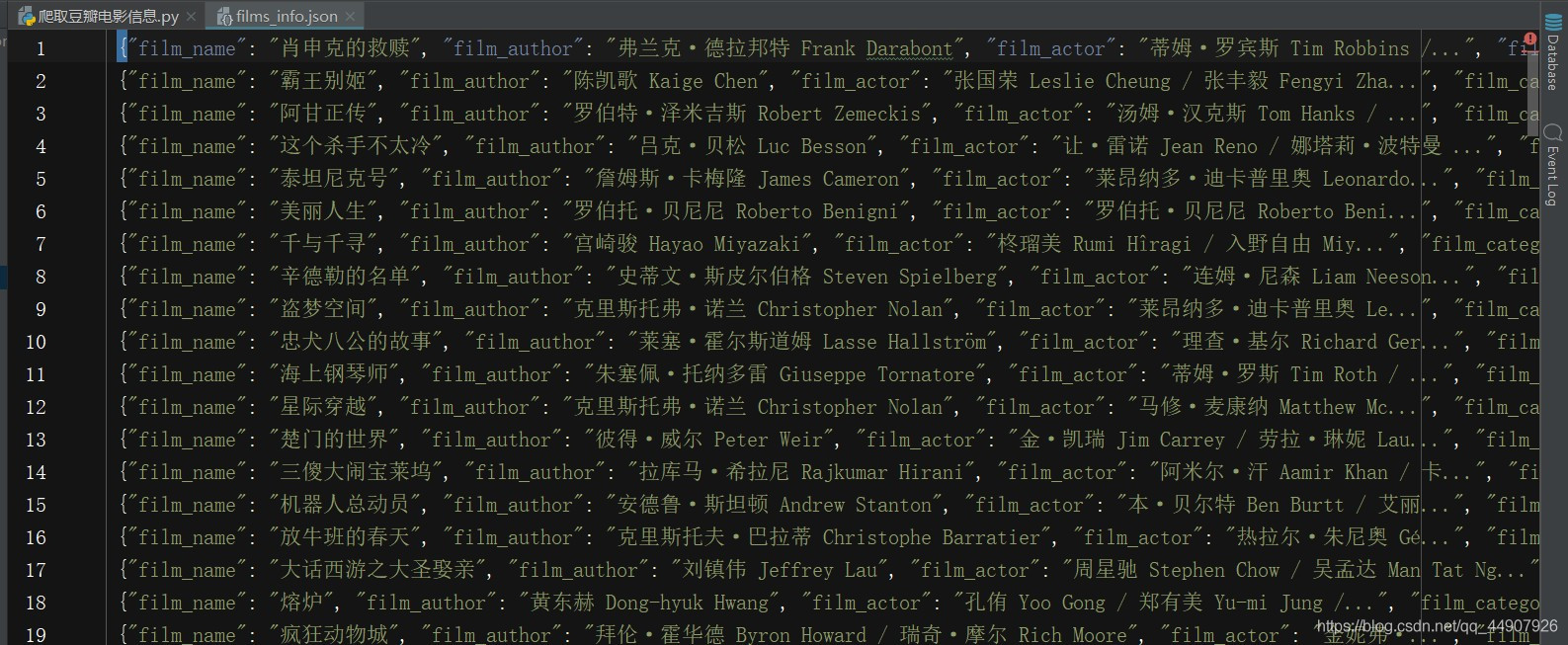

3.实现效果:可以完整正确无误的获取豆瓣Top250中的所有250部电影的目标信息!

第二部分:配合使用多线程提高效率!!!

关于线程的讲解!

import requests

from lxml import etree

import re

import json

from fake_useragent import UserAgent

import time

import threading

def films(num):

page_url="https://movie.douban.com/top250?start={}&filter=".format(num)

headers={

"User-Agent": UserAgent().random

}

res=requests.get(page_url,headers=headers)

html=etree.HTML(res.text)

film_info = {}

films_info = html.xpath("//div[@class='info']")

with open("films_info.json", 'a',encoding='utf-8') as f:

for film_one in films_info:

film_name = film_one.xpath("./div/a/span[1]/text()")[0]

film_author_actor = film_one.xpath("./div[2]/p/text()")[0].strip()

if "主" in film_author_actor:

film_author_test = re.findall(': (.*)\\xa0',film_author_actor)[0].strip()

film_author = re.sub('\\xa0','',film_author_test)

else:

film_author_test = re.findall(': (.*)',film_author_actor)[0]

film_author = re.sub('\\xa0', '', film_author_test)

if "主演" in film_author_actor and len(re.findall('\\xa0主演: (.*)',film_author_actor))==1:

film_actor_test = re.findall('\\xa0主演: (.*)',film_author_actor)[0].strip()

film_actor = re.sub('\\xa0','',film_actor_test)

else:

film_actor = "空"

film_category_test = film_one.xpath("./div[2]/p/text()")[1].strip()

film_category = re.sub('\\xa0','',film_category_test)

film_score = film_one.xpath("./div[2]/div/span[2]/text()")[0]

film_info["film_name"] = film_name

film_info["film_author"] = film_author

film_info["film_actor"] = film_actor

film_info["film_category"] = film_category

film_info["film_score"] = film_score

content = json.dumps(film_info,ensure_ascii=False) + "," + "\n"

f.write(content)

start_time = time.time()

for i in range(10):

thread_douban = threading.Thread(target=films,args=(i*25,))

thread_douban.start()

thread_douban.join()

end_time = time.time()

print(end_time-start_time)

cs