Spark大数据分析与实战:基于Spark MLlib 实现音乐推荐

基于Spark MLlib 实现音乐推荐

一、实验背景:

熟悉 Audioscrobbler 数据集

基于该数据集选择合适的 MLlib 库算法进行数据处理

进行音乐推荐(或用户推荐)

二、实验目的:

计算AUC评分最高的参数

利用AUC评分最高的参数,给用户推荐艺术家

对多个用户进行艺术家推荐

利用AUC评分最高的参数,给艺术家推荐喜欢他的用户

三、实验步骤:

- 安装Hadoop和Spark

- 启动Hadoop与Spark

- 将文件上传到 HDFS

- 实现音乐推荐

四、实验过程:

1、安装Hadoop和Spark

具体的安装过程在我以前的博客里面有,大家可以通过以下链接进入操作:

Hadoop的安装:https://blog.csdn.net/weixin_47580081/article/details/108647420

Scala及Spark的安装:https://blog.csdn.net/weixin_47580081/article/details/114250894

提示:如果IDEA未构建Spark项目,可以转接到以下的博客:

IDEA使用Maven构建Spark项目:https://blog.csdn.net/weixin_47580081/article/details/115435536

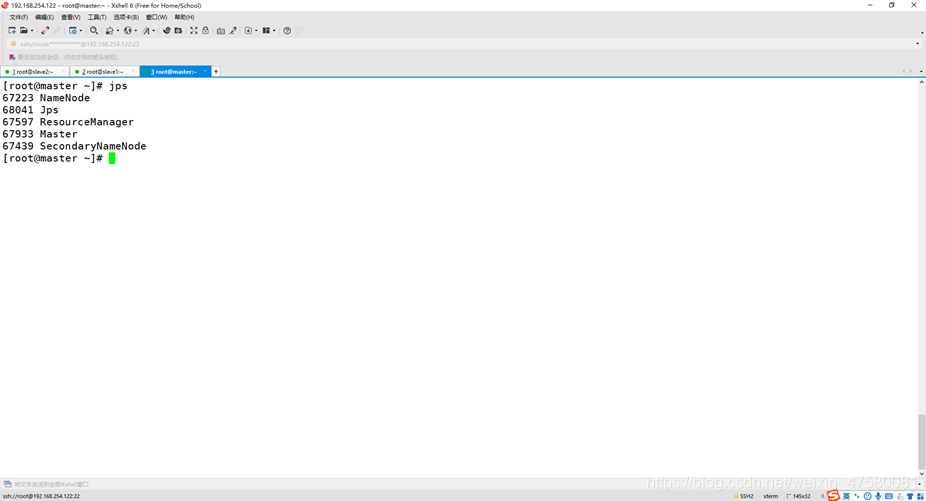

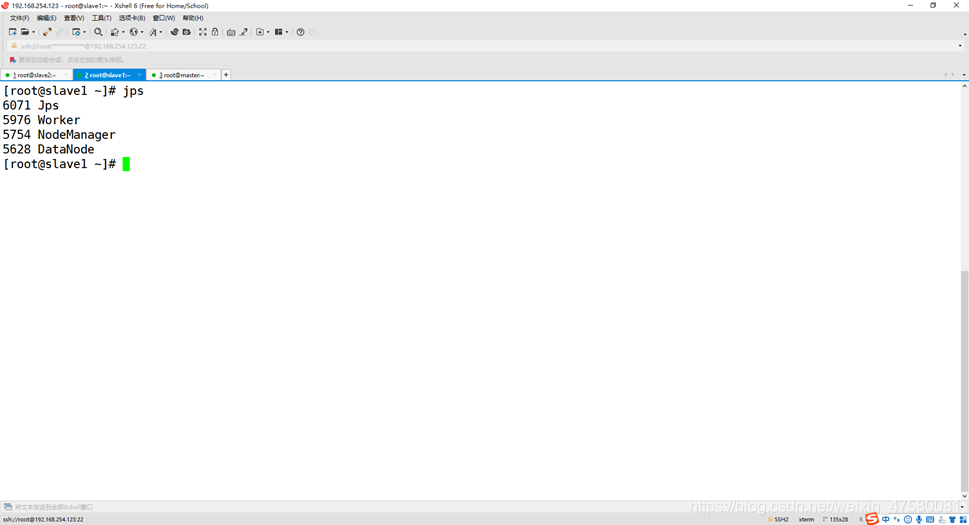

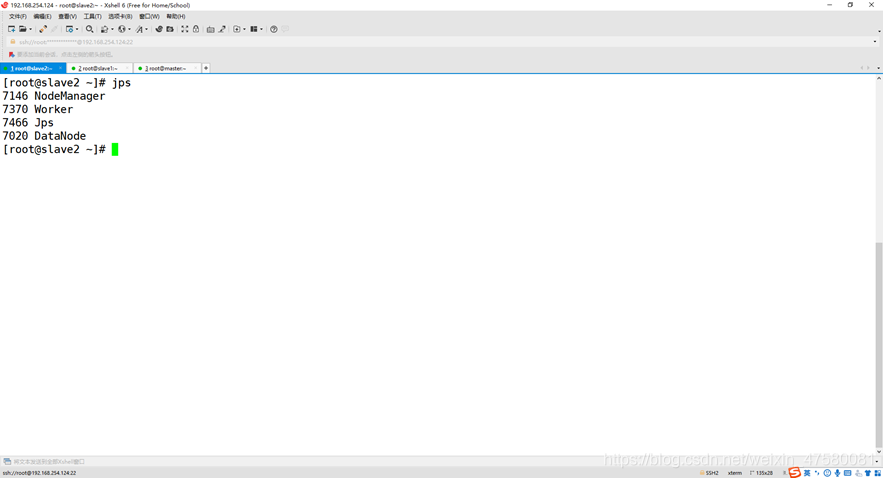

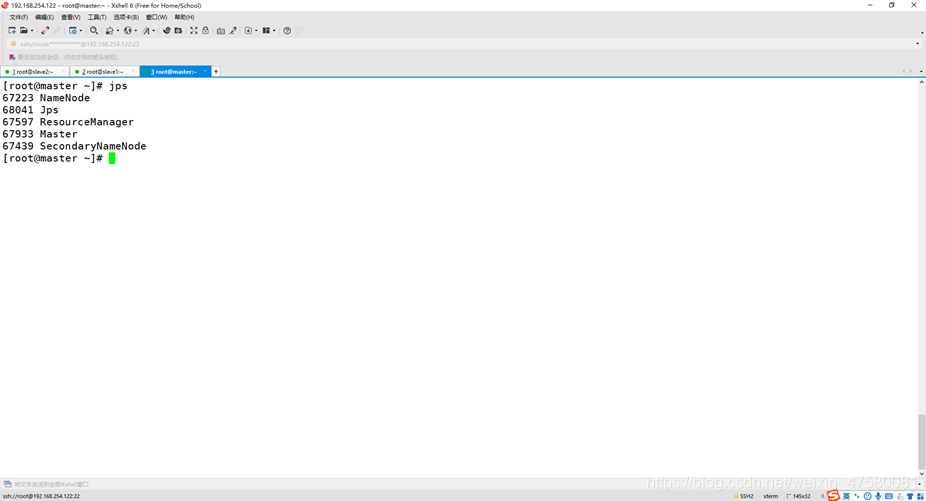

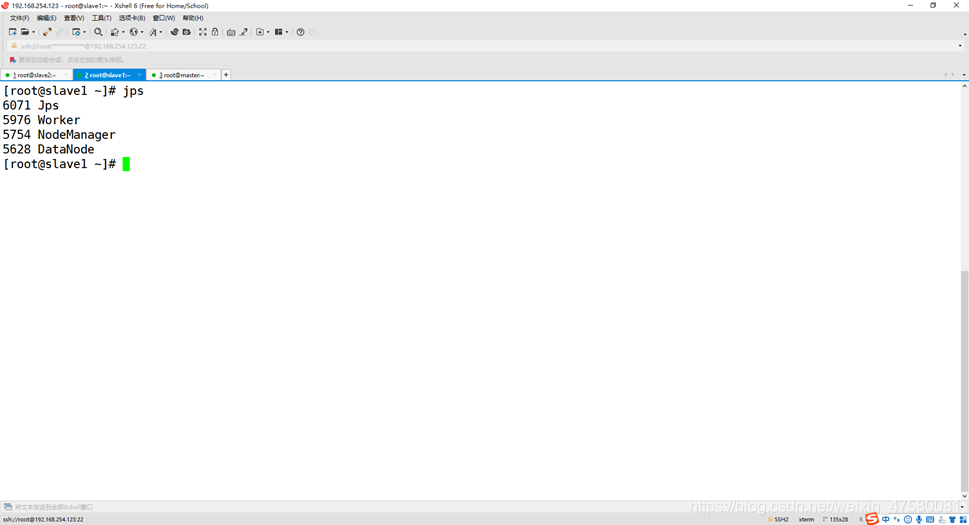

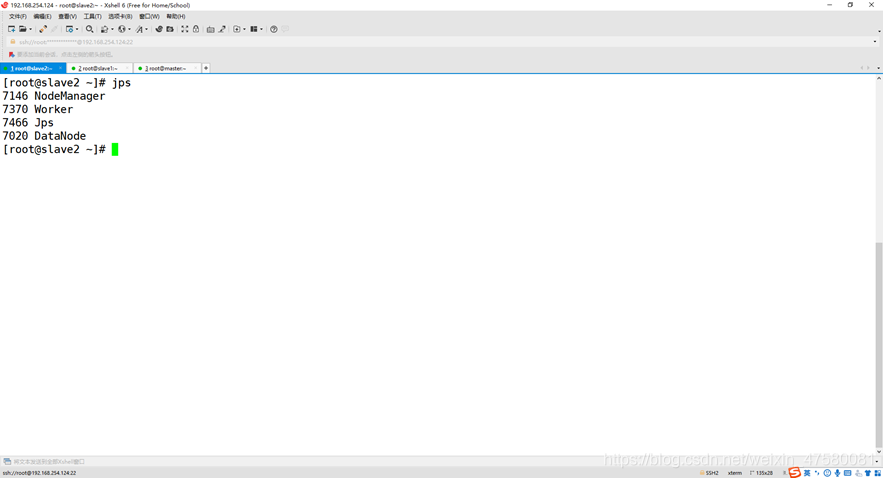

2、启动Hadoop与Spark

查看3个节点的进程

master

slave1

slave2

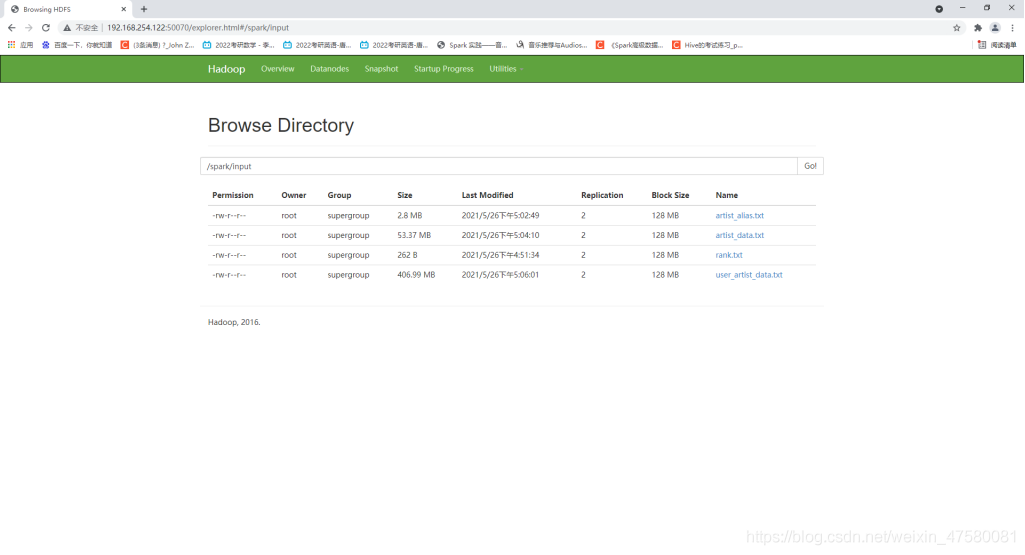

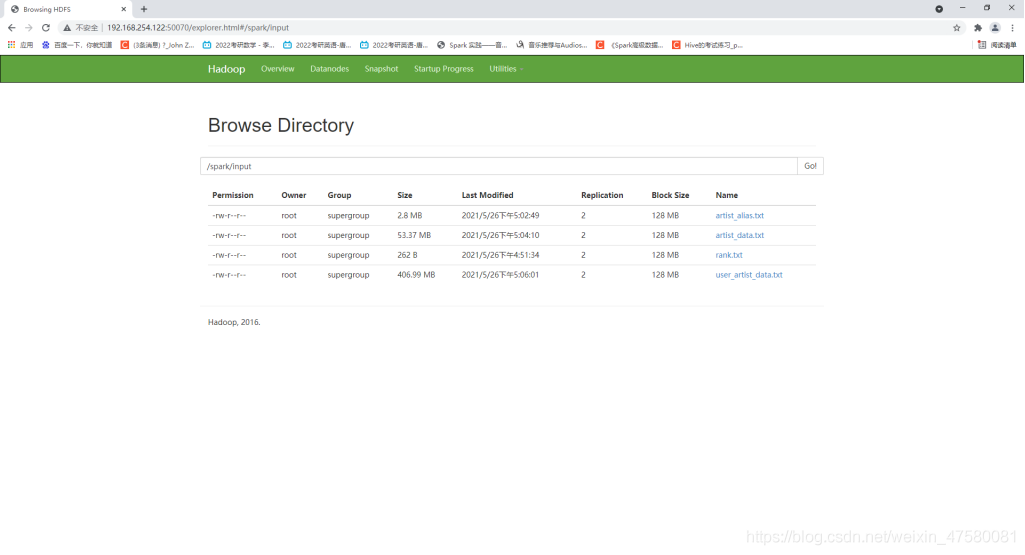

3、将文件上传到 HDFS

Shell命令:

[root@master ~]

[root@master profiledata_06-May-2005]

[root@master profiledata_06-May-2005]

4、实现音乐推荐

源代码:

package com.John.SparkProject

import org.apache.spark.SparkConf

import org.apache.spark.broadcast.Broadcast

import org.apache.spark.ml.recommendation.{ALS, ALSModel}

import org.apache.spark.sql.functions._

import org.apache.spark.sql.{DataFrame, Dataset, SparkSession}

import scala.collection.mutable.ArrayBuffer

import scala.util.Random

object project02 {

def main(args: Array[String]): Unit = {

val conf = new SparkConf()

.setMaster("local[2]")

.setAppName("Project02_RecommenderApp")

.set("spark.sql.crossJoin.enabled", "true")

val spark = new SparkSession.Builder()

.config(conf)

.getOrCreate()

import spark.implicits._

val rawArtistData = spark.read.textFile("hdfs://192.168.254.122:9000/spark/input/artist_data.txt")

val artistIdDF = transformArtistData(rawArtistData)

val artistIdDFtest = transformArtistData1(rawArtistData)

val rawAliasData = spark.read.textFile("hdfs://192.168.254.122:9000/spark/input/artist_alias.txt")

val artistAlias = transformAliasData(rawAliasData).collect().toMap

val rawUserArtistData = spark.read.textFile("hdfs://192.168.254.122:9000/spark/input/user_artist_data.txt")

val allDF = transformUserArtistData(spark, rawUserArtistData, artistAlias)

allDF.persist()

val Array(trainDF, testDF) = allDF.randomSplit(Array(0.9, 0.1))

trainDF.persist()

allDF.join(artistIdDFtest,"artist").select("name").filter("user='2093760'").show(5)

spark.stop()

}

def transformUserArtistData(spark: SparkSession, rawUserArtistDS: Dataset[String], artistAlias: Map[Int, Int]): DataFrame = {

import spark.implicits._

val bArtistAlias = spark.sparkContext.broadcast(artistAlias)

rawUserArtistDS.map(line => {

val Array(userId, artistId, count) = line.split(' ').map(_.toInt)

val finalArtistId = bArtistAlias.value.getOrElse(artistId, artistId)

(userId, finalArtistId, count)

}).toDF("user", "artist", "count").cache()

}

def transformArtistData(rawArtistData: Dataset[String]): DataFrame = {

import rawArtistData.sparkSession.implicits._

rawArtistData.flatMap(line => {

val (id, name) = line.span(_ != '\t')

try {

if (name.nonEmpty)

Some(id.toInt, name.trim)

else

None

} catch {

case _: Exception => None

}

}).toDF("id", "name").cache()

}

def transformArtistData1(rawArtistData: Dataset[String]): DataFrame = {

import rawArtistData.sparkSession.implicits.