初级抓取(限于“豆瓣电影”的各种选项,包括“热门”,“豆瓣高分”等十几个类别及评论,并打包exe)请看Python自定义豆瓣电影种类,排行,点评的爬取与存储(初级)

我发现了,我不是在写代码,我是在写BUG。。。

起因

不满足于豆瓣电影的各种抓取,而把魔爪伸向了豆瓣电视剧,所以整合起来了整个豆瓣影视的抓取,所以以后要不要再抓豆瓣读书啊。。。

目的

完成对豆瓣影视,包括豆瓣电影,豆瓣电视剧,豆瓣一周排行榜的自定义抓取及GUI界面设计及打包exe

方案

使用Tkinter+PhantomJS+Selenium+Firefox实现

实现过程

1.get到首页后,根据选择,点击种类,然后根据输入需求,进行排序 –这里的输入时listbox中值的点击键入

2.抓取每个电影及超链接,进入超链接后,抓取当前电影的热评及长评

3.当用户所要求TOP数目大于第一页的20个时候,点击加载更多,再出现20个电影,重复2操作。

4.将输出写入输出框架中,写入txt中等操作

实现效果

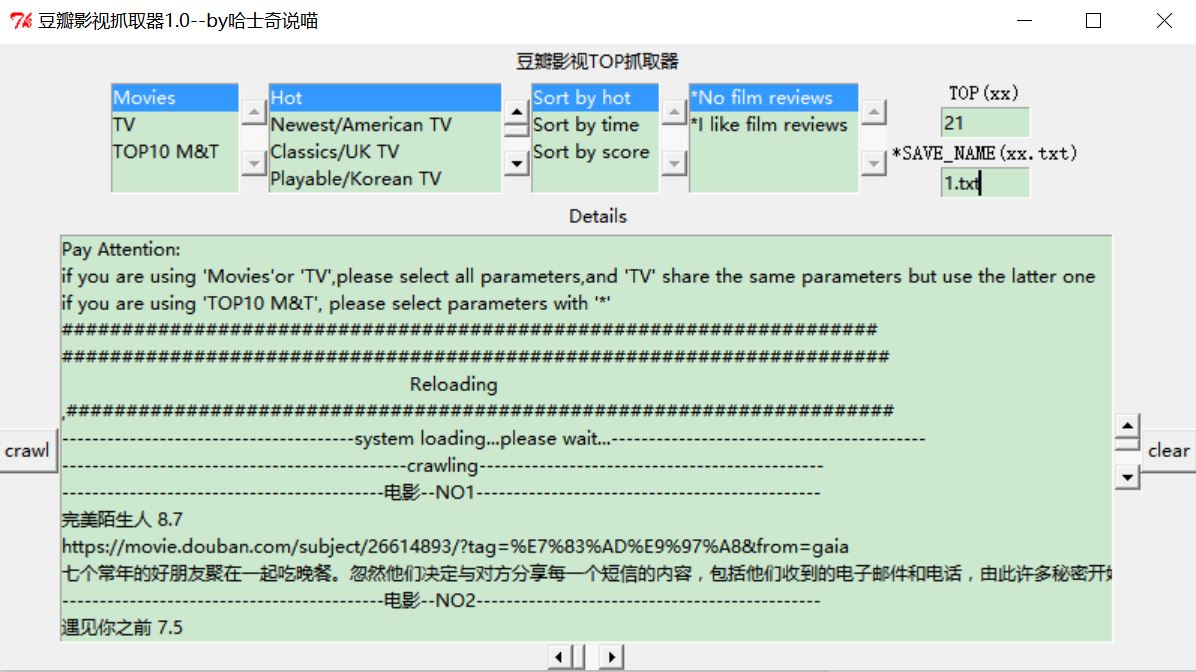

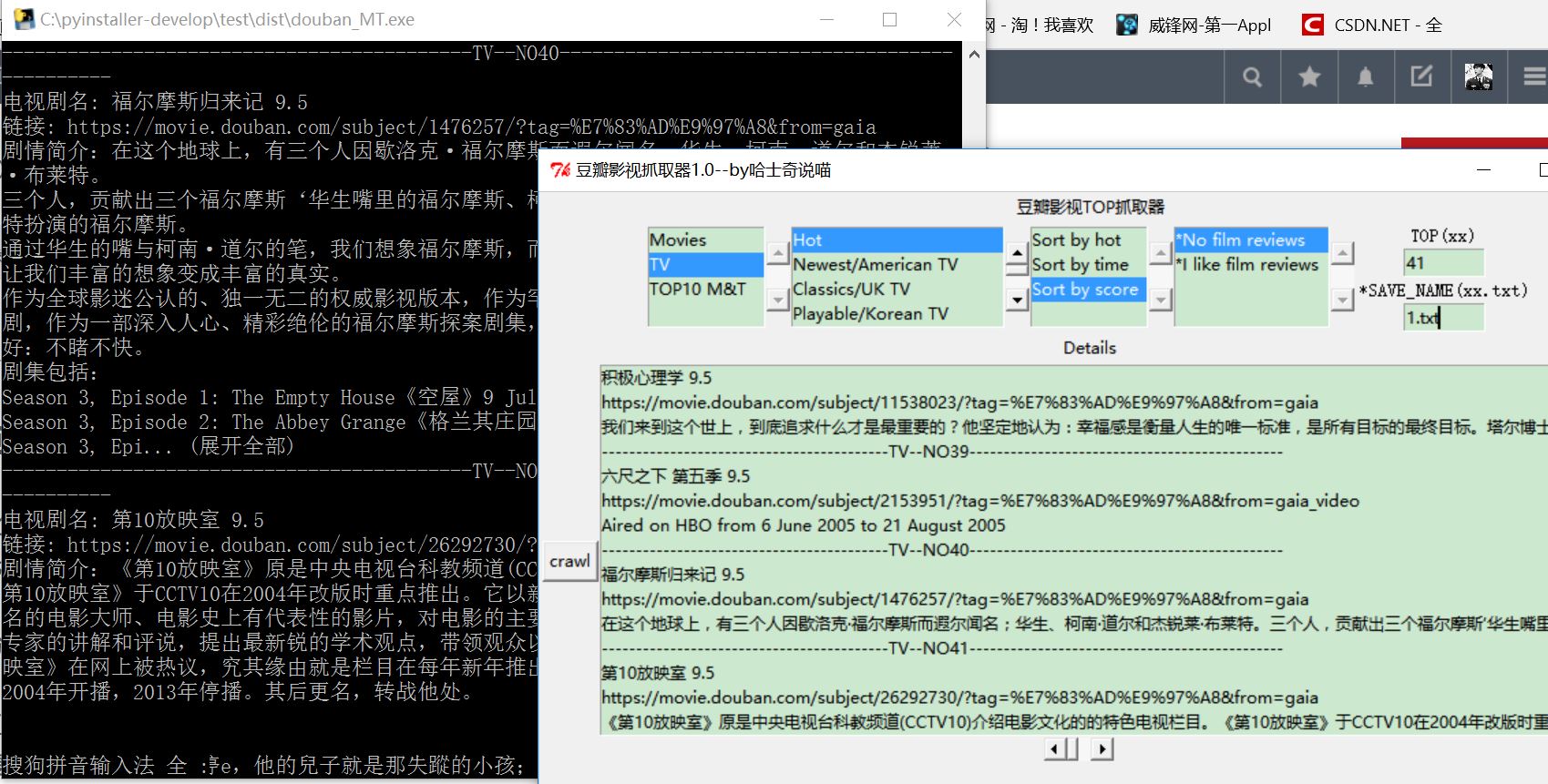

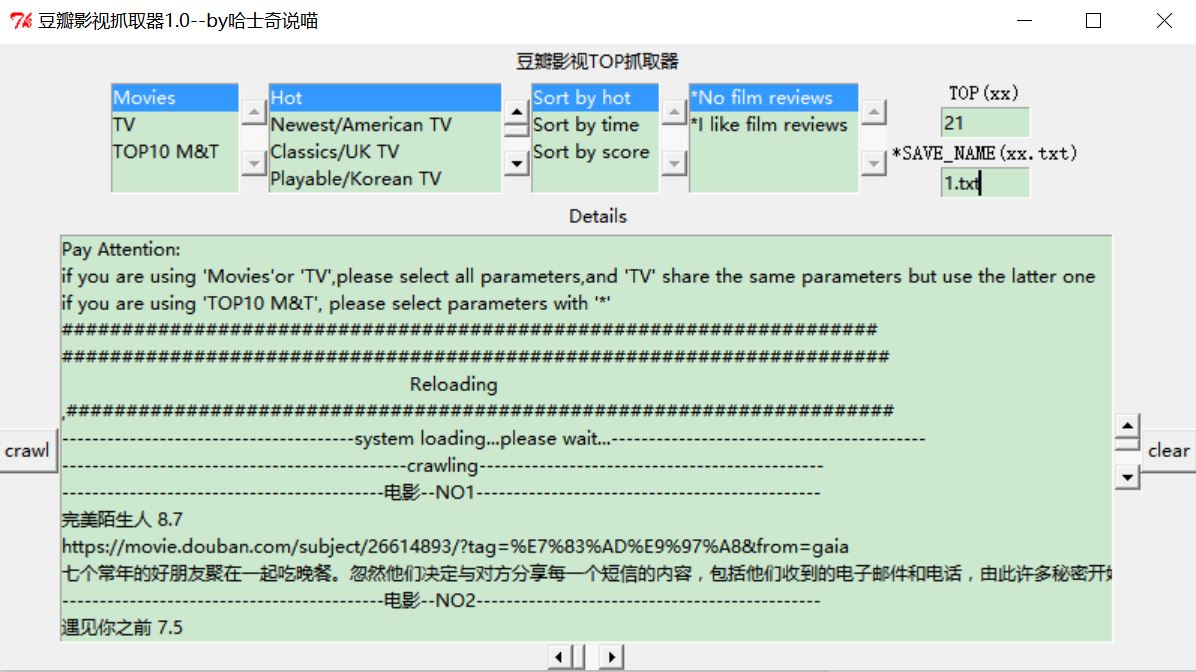

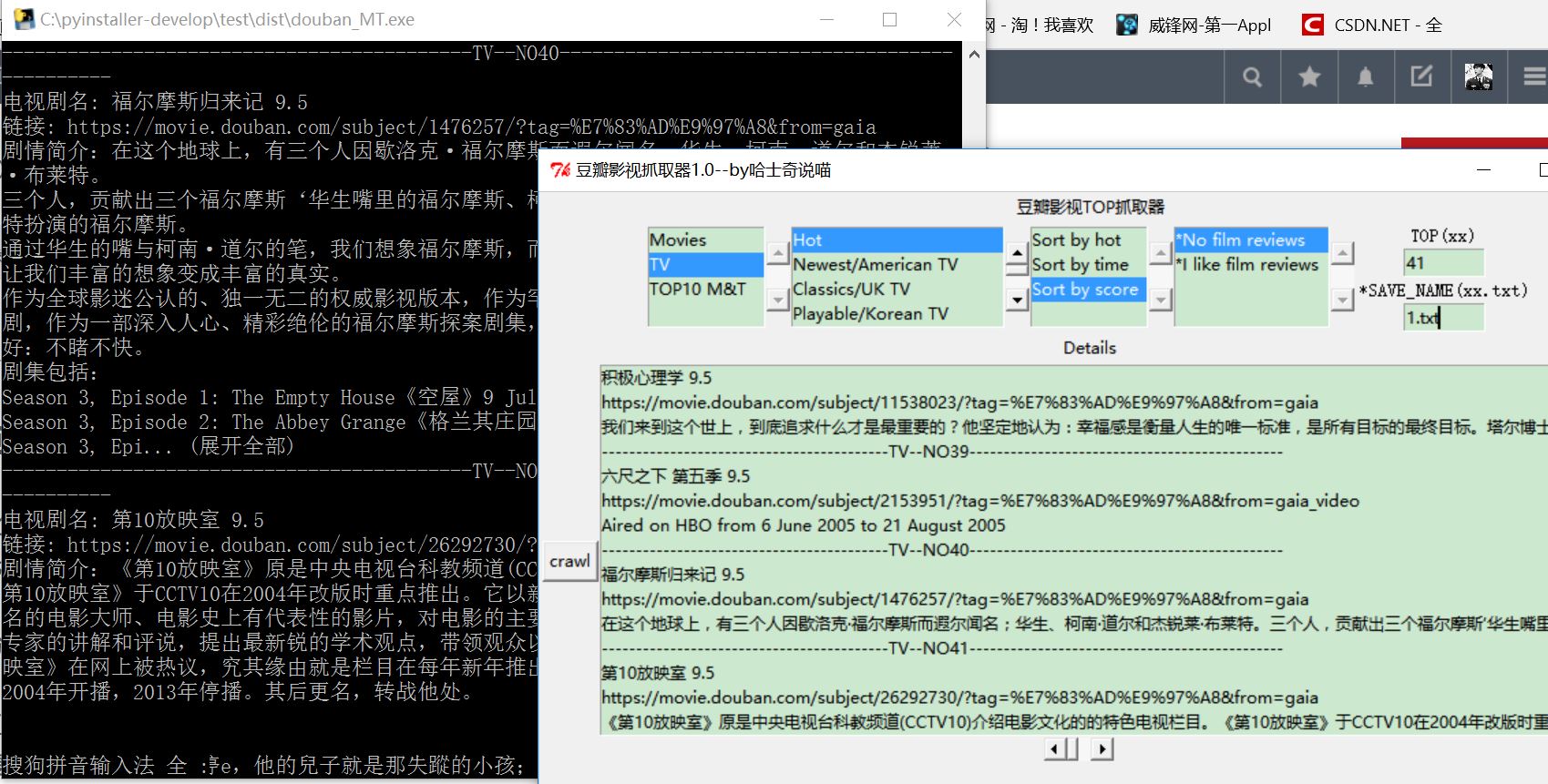

上图吧,这里第一项的影视选择键都可以实现相关操作,

这里说明一下,第一项,影视选择,第二项,类别选择(电视剧看后面项),第三项,排序方式,第四项,是否加载评论,第五项TOP多少,第六项,保存名称(需要格式为xx.txt)

下面是exe的版本

已上传资源,如有需要请点击这里进行下载

代码

from selenium import webdriver

import selenium.webdriver.support.ui as ui

import time

from Tkinter import *

print "---------------system loading...please wait...---------------"

def getURL_Title():

global save_name

SUMRESOURCES=0

url="https://movie.douban.com/"

driver_item=webdriver.Firefox()

wait = ui.WebDriverWait(driver_item,15)

Class_Dict={'Movies':1,'TV':2,'TOP10 M&T':3}

Kind_Dict={'Hot':1,'Newest/American TV':2,'Classics/UK TV':3,'Playable/Korean TV':4,'High Scores/Japanese TV':5,

'Wonderful but not popular/Chinese TV':6,'Chinese film/TVB':7,'Hollywood/Cartoon':8,

'Korea':9,'Japan':10,'Action movies':11,'Comedy':12,'Love story':13,

'Science fiction':14,'Thriller':15,'Horror film':16,'Whatever':17}

Sort_Dict={'Sort by hot':1,'Sort by time':2,'Sort by score':3}

Ask_Dict={'*No film reviews':0,'*I like film reviews':1}

try:

kind=Kind_Dict[Kind_Select.get(Kind_Select.curselection()).encode('utf-8')]

sort = Sort_Dict[Sort_Select.get(Sort_Select.curselection()).encode('utf-8')]

number = int(input_Top.get())

except:

print 'if you are using TOP10 M&T ,it\'s all right\n if not,please choice kind/sort/number '

class_MT = Class_Dict[MT_Select.get(MT_Select.curselection()).encode('utf=8')]

ask_comments = Ask_Dict[Comment_Select.get(Comment_Select.curselection()).encode('utf-8')]

save_name=input_SN.get()

Ans.insert(END,"#####################################################################")

Ans.insert(END," Reloading ")

Ans.insert(END,",#####################################################################")

Ans.insert(END,"---------------------------------------system loading...please wait...------------------------------------------")

Ans.insert(END,"----------------------------------------------crawling----------------------------------------------")

Write_txt('\n##########################################################################################','\n##########################################################################################',save_name)

print "---------------------crawling...---------------------"

if class_MT==1:

driver_item.get(url)

wait.until(lambda driver: driver.find_element_by_xpath("//div[@class='fliter-wp']/div/form/div/div/label[%s]"%kind))

driver_item.find_element_by_xpath("//div[@class='fliter-wp']/div/form/div/div/label[%s]"%kind).click()

wait.until(lambda driver: driver.find_element_by_xpath("//div[@class='fliter-wp']/div/form/div[3]/div/label[%s]"%sort))

driver_item.find_element_by_xpath("//div[@class='fliter-wp']/div/form/div[3]/div/label[%s]"%sort).click()

num=number+1

num_time = num/20+2

wait.until(lambda driver: driver.find_element_by_xpath("//div[@class='list-wp']/div/a[20]"))

for times in range(1,num_time):

driver_item.find_element_by_xpath("//div[@class='list-wp']/a[@class='more']").click()

wait.until(lambda driver: driver.find_element_by_xpath("//div[@class='list-wp']/div/a[%d]"%(20*(times+1))))

for i in range(1,num):

wait.until(lambda driver: driver.find_element_by_xpath("//div[@class='list']/a[%d]"%num))

list_title=driver_item.find_element_by_xpath("//div[@class='list']/a[%d]"%i)

print '----------------------------------------------'+'NO' + str(SUMRESOURCES +1)+'----------------------------------------------'

print u'电影名: ' + list_title.text

print u'链接: ' + list_title.get_attribute('href')

while list_title.text==driver_item.find_element_by_xpath("//div[@class='list']/a[%d]"%(i+20)).text:

print u'遇到页面加载重复项bug,开始重新加载...'

driver_item.quit()

getURL_Title()

list_title_wr=list_title.text.encode('utf-8')

list_title_url_wr=list_title.get_attribute('href')

Ans.insert(END,'\n-------------------------------------------Movies--'+'NO' + str(SUMRESOURCES +1)+'----------------------------------------------',list_title_wr,list_title_url_wr)

Write_txt('\n------------------------------------------Movies--'+'NO' + str(SUMRESOURCES +1)+'----------------------------------------------','',save_name)

Write_txt(list_title_wr,list_title_url_wr,save_name)

SUMRESOURCES = SUMRESOURCES +1

try:

getDetails(str(list_title.get_attribute('href')),ask_comments)

except:

print 'can not get the details!'

driver_item.quit()

if class_MT == 2:

driver_item.get(url)

wait.until(lambda driver: driver.find_element_by_xpath("//div[@class='fliter-wp']/h2/a[2]"))

driver_item.find_element_by_xpath("//div[@class='fliter-wp']/h2/a[2]").click()

wait.until(lambda driver: driver.find_element_by_xpath("//div[@class='fliter-wp']/div/form/div/div/label[%s]"%kind))

driver_item.find_element_by_xpath("//div[@class='fliter-wp']/div/form/div/div/label[%s]"%kind).click()

wait.until(lambda driver: driver.find_element_by_xpath("//div[@class='fliter-wp']/div/form/div[3]/div/label[%s]"%sort))

driver_item.find_element_by_xpath("//div[@class='fliter-wp']/div/form/div[3]/div/label[%s]"%sort).click()

num=number+1

num_time = num/20+2

wait.until(lambda driver: driver.find_element_by_xpath("//div[@class='list-wp']/div/a[20]"))

for times in range(1,num_time):

driver_item.find_element_by_xpath("//div[@class='list-wp']//a[@class='more']").click()

wait.until(lambda driver: driver.find_element_by_xpath("//div[@class='list-wp']/div/a[%d]"%(20*(times+1))))

for i in range(1,num):

wait.until(lambda driver: driver.find_element_by_xpath("//div[@class='list']/a[%d]"%num))

list_title=driver_item.find_element_by_xpath("//div[@class='list']/a[%d]"%i)

print '-------------------------------------------TV--'+'NO' + str(SUMRESOURCES +1)+'----------------------------------------------'

print u'电视剧名: ' + list_title.text

print u'链接: ' + list_title.get_attribute('href')

while list_title.text==driver_item.find_element_by_xpath("//div[@class='list']/a[%d]"%(i+20)).text:

print u'遇到页面加载重复项bug,开始重新加载...'

driver_item.quit()

getURL_Title()

list_title_wr=list_title.text.encode('utf-8')

list_title_url_wr=list_title.get_attribute('href')

Ans.insert(END,'\n------------------------------------------TV--'+'NO' + str(SUMRESOURCES +1)+'----------------------------------------------',list_title_wr,list_title_url_wr)

Write_txt('\n----------------------------------------TV--'+'NO' + str(SUMRESOURCES +1)+'----------------------------------------------','',save_name)

Write_txt(list_title_wr,list_title_url_wr,save_name)

SUMRESOURCES = SUMRESOURCES +1

try:

getDetails(str(list_title.get_attribute('href')),ask_comments)

except:

print 'can not get the details!'

driver_item.quit()

if class_MT==3:

driver_item.get(url)

for i in range(1,11):

wait.until(lambda driver: driver.find_element_by_xpath("//div[@class='billboard-bd']/table/tbody/tr"))

list_title=driver_item.find_element_by_xpath("//div[@class='billboard-bd']/table/tbody/tr[%d]/td[2]/a"%i)

print '----------------------------------------------'+'NO' + str(SUMRESOURCES +1)+'----------------------------------------------'

print u'影视名: ' + list_title.text

print u'链接: ' + list_title.get_attribute('href')

list_title_wr=list_title.text.encode('utf-8')

list_title_url_wr=list_title.get_attribute('href')

Ans.insert(END,'\n-------------------------------------------WeekTOP--'+'NO' + str(SUMRESOURCES +1)+'----------------------------------------------',list_title_wr,list_title_url_wr)

Write_txt('\n------------------------------------------WeekTOP--'+'NO' + str(SUMRESOURCES +1)+'----------------------------------------------','',save_name)

Write_txt(list_title_wr,list_title_url_wr,save_name)

SUMRESOURCES = SUMRESOURCES +1

try:

getDetails(str(list_title.get_attribute('href')),ask_comments)

except:

print 'can not get the details!'

driver_item.quit()

def getDetails(url,comments):

driver_detail = webdriver.PhantomJS(executable_path="phantomjs.exe")

wait1 = ui.WebDriverWait(driver_detail,15)

driver_detail.get(url)

wait1.until(lambda driver: driver.find_element_by_xpath("//div[@id='link-report']/span"))

drama = driver_detail.find_element_by_xpath("//div[@id='link-report']/span")

print u"剧情简介:"+drama.text

drama_wr=drama.text.encode('utf-8')

Ans.insert(END,drama_wr)

Write_txt(drama_wr,'',save_name)

if comments == 1:

print "--------------------------------------------Hot comments TOP----------------------------------------------"

for i in range(1,5):

try:

comments_hot = driver_detail.find_element_by_xpath("//div[@id='hot-comments']/div[%s]/div/p"%i)

print u"最新热评:"+comments_hot.text

comments_hot_wr=comments_hot.text.encode('utf-8')

Ans.insert(END,"--------------------------------------------Hot comments TOP%d----------------------------------------------"%i,comments_hot_wr)

Write_txt("--------------------------------------------Hot comments TOP%d----------------------------------------------"%i,'',save_name)

Write_txt(comments_hot_wr,'',save_name)

except:

print 'can not caught the comments!'

try:

driver_detail.find_element_by_xpath("//img[@class='bn-arrow']").click()

time.sleep(1)

comments_get = driver_detail.find_element_by_xpath("//div[@class='review-bd']/div[2]/div")

if comments_get.text.encode('utf-8')=='提示: 这篇影评可能有剧透':

comments_deep=driver_detail.find_element_by_xpath("//div[@class='review-bd']/div[2]/div[2]")

else:

comments_deep = comments_get

print "--------------------------------------------long-comments---------------------------------------------"

print u"深度长评:"+comments_deep.text

comments_deep_wr=comments_deep.text.encode('utf-8')

Ans.insert(END,"--------------------------------------------long-comments---------------------------------------------\n",comments_deep_wr)

Write_txt("--------------------------------------------long-comments---------------------------------------------\n",'',save_name)

Write_txt(comments_deep_wr,'',save_name)

except:

print 'can not caught the deep_comments!'